Wie der Ball schneller zum Zuschauer kommt - Sport-Livestreaming (fast) ohne Verzögerung

Alle Jahre wieder taucht ein sehr technischer Begriff in der Berichterstattung rund um Sportgroßveranstaltungen auf, der wenig Freunde hat und als Stimmungskiller Nummer 1 für das Live-Publikum gilt: Die Latenz.

Gemeint sind damit die Verzögerungen der unterschiedlichen TV-Empfangswege, die ihre Signale nicht alle parallel erhalten. In Abhängigkeit von unterschiedlichen Übertragungskanälen wie Antenne (DVB-T2), Digitalkabel oder Streaming-Diensten im Internet kommen diverse technische Faktoren ins Spiel, die für Ungleichheit beim Torjubel sorgen. Der Begriff "Liveübertragung" ist also dehnbar.

Noch bis vor kurzem galt dabei das Netz mit seinen Streaming-Diensten, Apps und Pay-per-View-Angeboten als langsamster Kanal - im Vergleich zu Satellitensignalen war von Verzögerungszeiten bis zu mehreren Minuten die Rede. Dazu seinerzeit Heise mit einem Bericht zur Fußball-WM 2014: "Wer Internet-Dienste nutzt, um am Ball zu bleiben, hat meist noch locker Zeit, das Smartphone aus der Tasche zu ziehen, die App zu starten und dann dort "live" das Tor fallen zu sehen, das die anderen schon längst bejubelt haben."

Aber: Online wächst und Fernsehen verlagert sich zunehmend ins Internet. Die Technik wird permanent weiterentwickelt und die Minimierung von Latenzen ist gerade bei uns als Streaming-Dienstleister nicht nur Tagesgeschäft, sondern Leidenschaft. Wir freuen uns dabei sehr, wenn unser Know-How in dem ein oder anderen Live-Angebot zu Sport-Großveranstaltungen erfolgreich zum Einsatz kommt.

Konkrete Beispiele und Referenzen nennen wir übrigens gerne auf Anfrage. Erste Messungen anlässlich aktueller Sport-Events im Sommer 2018 ergaben hier Latenz-Optimierungen von vormals 60 Sekunden auf 5 Sekunden im Vergleich zum Satelliten-Signal (DVB-S2).

Welche Technik kommt zum Einsatz?

Wir haben zur Optimierung der Latenzen im Wesentlichen auf eine Verkürzung der Segmente gesetzt. Für das HTTP-Livestreaming werden die Medieninhalte in kleine Einzelvideos von bestimmter Länge unterteilt (segmentiert). Diese Segmente werden per HTTP ausgeliefert und im Endgerät des Nutzers (Player) als ununterbrochener Stream wiedergegeben.

Die Auslieferung eines Livestreams erfolgt dabei in der Regel zusätzlich in Abhängigkeit von den aktuellen Verbindungsbedingungen beim Endbenutzer, es wird also die jeweils optimale Qualität (höchstmögliche Bitrate) bereitgestellt. Die Bildqualität der Streams passt sich den Empfangsbedingungen beim Endnutzer an. Befindet sich das Endgerät in einem WLAN, wird eine maximale Bildqualität mit höchster Qualität angeboten. Sitzen die Nutzer beispielsweise im Zug mit einer geringen Empfangsqualität, wird die Datenrate gedrosselt und die Qualität reduziert.

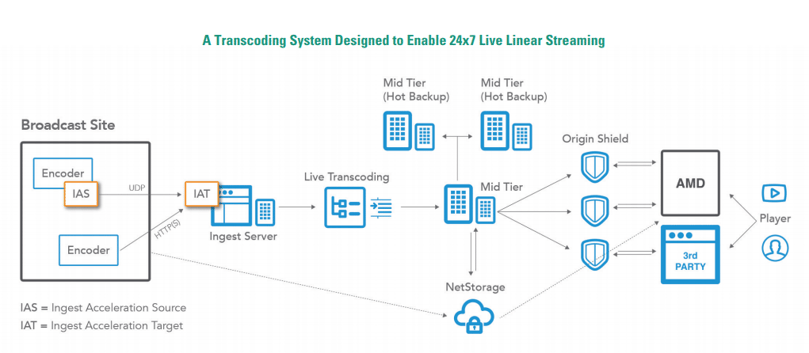

Die Verbreitung von HTTP-Streams mit kurzen Segmentlängen bringt aber einen massiven Anstieg der Anfragen auf die ausliefernden Server mit sich - und setzt für einen reibungslosen Ablauf eine hoch performante Plattform voraus, die uns die Kollegen von Akamai mit ihren "Media Services Live 4" zur Verfügung stellen.

Zum Thema Latenzen noch einige spannende Ressourcen unserer Technologie-Partner:

- https://developer.akamai.com/edge-2017/videos/the-road-to-ultra-low-latency

Der Weg zu extrem niedrigen Latenzzeiten: Die Bereitstellung von "better than broadcast"-Live-Streams stellt eine Reihe von technischen Herausforderungen dar, und das Erreichen extrem niedriger Latenzzeiten steht sicherlich ganz oben auf der Liste. Aber "Herausforderung" heißt nicht unmöglich. In dieser Präsentation erfahren Sie, wie Sie die neuesten Funktionen des Common Media Application Format (CMAF) mit Akamai Media Services Live nutzen können, um Live-Streams mit extrem niedriger Latenzzeit für beeindruckende Videoerlebnisse zu erstellen.

- https://www.wowza.com/blog/what-is-low-latency-and-who-needs-it

Was ist niedrige Latenzzeit? Wenn einige Sekunden Latenz normal sind, was ist dann niedrige Latenz? Es ist ein subjektiver Begriff. Das beliebte Apple HLS-Streaming-Protokoll ist standardmäßig auf 30 bis 45 Sekunden Latenzzeit eingestellt. Wenn man also von niedriger Latenz spricht, spricht man oft davon, diese auf fünf bis sieben Sekunden zu reduzieren: ähnlich dem, was man beim herkömmlichen Fernsehen erwarten würde. - https://aws.amazon.com/de/blogs/media/how-to-compete-with-broadcast-latency-using-current-adaptive-bitrate-technologies-part-1/

Warum ist Latenz ein Problem beim Live-Video-Streaming? Wann immer die Auslieferung von Inhalten zeitkritisch ist, egal ob es sich um TV-Inhalte wie Sport, Spiele oder Nachrichten oder reine OTT-Inhalte wie eSport oder Glücksspiel handelt, können Sie sich keine Verzögerung leisten. Warten tötet die Spannung, Warten macht Sie zu einem Bürger zweiter Klasse in der Welt der Unterhaltung und Echtzeit-Informationen. Ein offensichtliches Beispiel ist das Zuschauen eines Fußballspiels: Ihr Nachbar schaut es im traditionellen Fernsehen und schreit durch die Wände auf jedem Tor seiner Lieblingsmannschaft, normalerweise das gleiche wie bei Ihnen, während Sie 25 oder 30 Sekunden warten müssen, bevor Sie das gleiche Tor mit Ihrem OTT-Service sehen können. Das ist sehr frustrierend, und ähnlich wie wenn die Ergebnisse Ihres Lieblingsgesangswettbewerbs durch einen Twitter- oder Facebook-Feed verdorben werden, den Sie neben dem Streaming-Kanal überwachen. Diese sozialen Feeds werden in der Regel von Nutzern generiert, die die Sendung auf ihrem eigenen Fernseher sehen, so dass Ihre vergleichende Latenzzeit in der Regel auf 15 bis 20 Sekunden sinkt, aber Sie sind immer noch deutlich hinter dem Live-TV zurück.